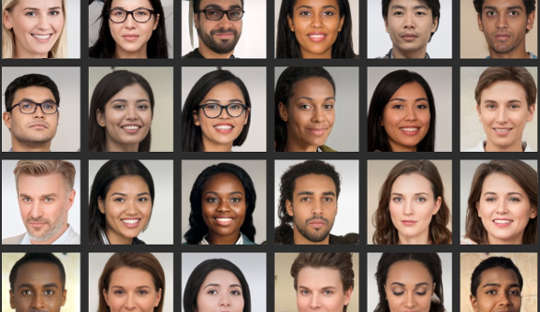

Mesmo que você ache que é bom em analisar rostos, a pesquisa mostra muitas pessoas não conseguem distinguir com segurança entre fotos de rostos reais e imagens geradas por computador. Isso é particularmente problemático agora que os sistemas de computador podem criar fotos realistas de pessoas que não existem.

Recentemente, um perfil falso do LinkedIn com uma foto de perfil gerada por computador virou notícia porque conectado com sucesso com funcionários dos EUA e outros indivíduos influentes na plataforma de rede, por exemplo. Especialistas em contra-espionagem dizem até que os espiões criam rotineiramente perfis fantasmas com essas fotos para em alvos estrangeiros através da mídia social.

Essas falsificações profundas estão se tornando comuns na cultura cotidiana, o que significa que as pessoas devem estar mais cientes de como estão sendo usadas em marketing, publicidade e mídia social. As imagens também estão sendo usadas para fins maliciosos, como propaganda política, espionagem e guerra de informação.

Fazê-los envolve algo chamado rede neural profunda, um sistema de computador que imita a maneira como o cérebro aprende. Isso é “treinado” pela exposição a conjuntos de dados cada vez maiores de rostos reais.

Na verdade, duas redes neurais profundas são colocadas uma contra a outra, competindo para produzir as imagens mais realistas. Como resultado, os produtos finais são chamados de imagens GAN, onde GAN significa Generative Adversarial Networks. O processo gera novas imagens que são estatisticamente indistinguíveis das imagens de treinamento.

Em nosso estudo publicado na iScience, mostramos que a falha em distinguir esses rostos artificiais dos reais tem implicações em nosso comportamento online. Nossa pesquisa sugere que as imagens falsas podem corroer nossa confiança nos outros e mudar profundamente a forma como nos comunicamos online.

Meus colegas e eu descobrimos que as pessoas percebiam os rostos GAN como sendo ainda mais reais do que fotos genuínas de rostos de pessoas reais. Embora ainda não esteja claro por que isso ocorre, essa descoberta não destacar os recentes avanços na tecnologia usado para gerar imagens artificiais.

E também encontramos uma ligação interessante com a atratividade: rostos classificados como menos atraentes também foram classificados como mais reais. Rostos menos atraentes podem ser considerados mais típicos e a face típica pode ser usada como referência contra o qual todas as faces são avaliadas. Portanto, esses rostos GAN pareceriam mais reais porque são mais semelhantes aos modelos mentais que as pessoas construíram na vida cotidiana.

Mas ver esses rostos artificiais como autênticos também pode ter consequências para os níveis gerais de confiança que estendemos a um círculo de pessoas desconhecidas – um conceito conhecido como “confiança social”.

Freqüentemente, lemos muito nos rostos que vemos, e o primeiras impressões que formamos orientam nossas interações sociais. Em um segundo experimento que fez parte de nosso estudo mais recente, vimos que as pessoas eram mais propensas a confiar em informações transmitidas por rostos que haviam julgado reais, mesmo que fossem gerados artificialmente.

Não é de surpreender que as pessoas depositem mais confiança em rostos que acreditam ser reais. Mas descobrimos que a confiança foi corroída quando as pessoas foram informadas sobre a possível presença de rostos artificiais em interações online. Eles então mostraram níveis mais baixos de confiança, em geral – independentemente de os rostos serem reais ou não.

Este resultado pode ser considerado útil em alguns aspectos, porque tornou as pessoas mais suspeitas em um ambiente onde usuários falsos podem operar. De outra perspectiva, no entanto, pode corroer gradualmente a própria natureza de como nos comunicamos.

Em geral, tendemos a operar em uma suposição padrão de que outras pessoas são basicamente verdadeiras e confiáveis. O crescimento de perfis falsos e outros conteúdos artificiais online levanta a questão de quanto sua presença e nosso conhecimento sobre eles podem alterar esse estado de “padrão da verdade”, acabando por corroer a confiança social.

Mudando nossos padrões

A transição para um mundo onde o que é real é indistinguível do que não é também pode mudar a paisagem cultural de ser principalmente verdadeira para ser principalmente artificial e enganosa.

Se questionarmos regularmente a veracidade do que experimentamos online, isso pode exigir que redistribuamos nosso esforço mental do processamento das próprias mensagens para o processamento da identidade do mensageiro. Em outras palavras, o uso generalizado de conteúdo on-line altamente realista, mas artificial, pode exigir que pensemos de maneira diferente – de maneiras que não esperávamos.

Em psicologia, usamos um termo chamado “monitoramento da realidade” para identificar corretamente se algo está vindo do mundo externo ou de dentro de nossos cérebros. O avanço das tecnologias que podem produzir rostos, imagens e chamadas de vídeo falsos, mas altamente realistas, significa que o monitoramento da realidade deve ser baseado em informações diferentes de nossos próprios julgamentos. Também exige uma discussão mais ampla sobre se a humanidade ainda pode se dar ao luxo de omitir a verdade.

É crucial que as pessoas sejam mais críticas ao avaliar rostos digitais. Isso pode incluir o uso de pesquisas de imagens reversas para verificar se as fotos são genuínas, desconfiar de perfis de mídia social com poucas informações pessoais ou um grande número de seguidores e estar ciente do potencial da tecnologia deepfake ser usada para fins nefastos.

A próxima fronteira para esta área deve ser algoritmos aprimorados para detectar rostos digitais falsos. Estes poderiam então ser incorporados em plataformas de mídia social para nos ajudar a distinguir o real do falso quando se trata de rostos de novas conexões.

Sobre o autor

Manos Tsakiris, Professora de Psicologia, Diretora do Centro de Políticas dos Sentimentos, Royal Holloway University of London

Este artigo foi republicado a partir de A Conversação sob uma licença Creative Commons. Leia o artigo original.