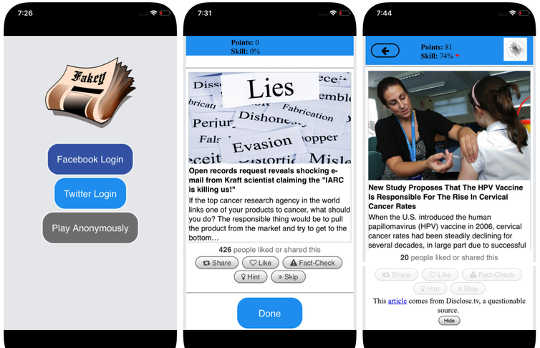

Capturas de tela do jogo Fakey. Mihai Avram e Filippo Menczer

Capturas de tela do jogo Fakey. Mihai Avram e Filippo Menczer

As mídias sociais estão entre as fontes primárias de notícias nos EUA e em todo o mundo. No entanto, os usuários estão expostos a conteúdo de precisão questionável, incluindo teorias da conspiração, Clickbait, conteúdo hiperpartidário, pseudo ciência e até mesmo relatórios falsificados de notícias falsas.

Não é de surpreender que haja muita desinformação publicada: spam e fraudes on-line são lucrativos para criminosose propaganda do governo e propaganda política benefícios partidários e financeiros. Mas o fato de que conteúdo de baixa credibilidade se espalha tão rápida e facilmente sugere que as pessoas e os algoritmos por trás das plataformas de mídia social são vulneráveis à manipulação.

Nossa pesquisa identificou três tipos de preconceitos que tornam o ecossistema de mídia social vulnerável a desinformação intencional e acidental. É por isso que nossos Observatório de Mídias Sociais na Universidade de Indiana está construindo ferramentas para ajudar as pessoas a se conscientizarem dessas tendências e se protegerem de influências externas criadas para explorá-las.

Explicando as ferramentas desenvolvidas no Observatório de Mídias Sociais:

{youtube}https://youtu.be/BIv9054dBBI{/youtube}

Viés no cérebro

Os preconceitos cognitivos se originam na maneira como o cérebro processa as informações que cada pessoa encontra todos os dias. O cérebro pode lidar apenas com uma quantidade finita de informação, e muitos estímulos recebidos podem causar sobrecarga de informação. Isso por si só tem sérias implicações para a qualidade da informação nas mídias sociais. Descobrimos que a concorrência acirrada pela atenção limitada dos usuários significa que algumas ideias se tornam virais apesar de sua baixa qualidade - mesmo quando as pessoas preferem compartilhar conteúdo de alta qualidade.

Para evitar ficar sobrecarregado, o cérebro usa um número de truques. Estes métodos são geralmente eficazes, mas também podem tornar-se preconceitos quando aplicado em contextos errados.

Um atalho cognitivo acontece quando uma pessoa decide se compartilha uma história que aparece em seu feed de mídia social. As pessoas são muito afetada pelas conotações emocionais de uma manchete, embora não seja um bom indicador da precisão de um artigo. Muito mais importante é quem escreveu a peça.

Para contrariar este preconceito e ajudar as pessoas a prestarem mais atenção à fonte de uma reivindicação antes de a partilhar, desenvolvemos Fakey, um jogo de alfabetização de notícias para celular Android e iOS) simulando um feed de notícias típico de mídia social, com uma mistura de artigos de notícias de fontes tradicionais e de baixa credibilidade. Os jogadores ganham mais pontos por compartilhar notícias de fontes confiáveis e sinalizar conteúdo suspeito para verificação de fatos. No processo, eles aprendem a reconhecer sinais de credibilidade da fonte, como reivindicações de hiperpartidários e manchetes com carga emocional.

Viés na sociedade

Outra fonte de preconceito vem da sociedade. Quando as pessoas se conectam diretamente com seus pares, os preconceitos sociais que guiam sua seleção de amigos influenciam as informações que eles veem.

De fato, em nossa pesquisa descobrimos que é possível determinar as inclinações políticas de um usuário do Twitter simplesmente olhando para as preferências partidárias de seus amigos. Nossa análise da estrutura desses redes de comunicação partidárias As redes sociais são particularmente eficientes na divulgação de informações - precisas ou não - quando eles estão intimamente ligados e desconectados de outras partes da sociedade.

A tendência de avaliar a informação mais favoravelmente, se vier de dentro de seus próprios círculos sociais, cria “câmaras de eco”Que estão prontos para a manipulação, seja consciente ou não. Isso ajuda a explicar por que tantas conversas on-line Confrontos "nós contra eles".

Para estudar como a estrutura das redes sociais online torna os usuários vulneráveis à desinformação, construímos Hoaxy, um sistema que rastreia e visualiza a disseminação de conteúdo de fontes de baixa credibilidade e como ele compete com o conteúdo de verificação de fatos. Nossa análise dos dados coletados por Hoaxy durante as eleições presidenciais norte-americanas da 2016 mostra que as contas do Twitter que compartilharam desinformação foram quase completamente cortado das correções feitas pelos verificadores de fatos.

Quando analisamos as contas de disseminação de informações incorretas, encontramos um grupo muito denso de contas retweetando umas às outras quase exclusivamente - incluindo vários bots. As únicas vezes em que as organizações de checagem de fatos foram citadas ou mencionadas pelos usuários no grupo mal informado foram quando questionaram sua legitimidade ou alegaram o contrário do que escreveram.

Preconceito na máquina

O terceiro grupo de preconceitos surge diretamente dos algoritmos usados para determinar o que as pessoas veem on-line. Ambas as plataformas de mídia social e os mecanismos de pesquisa as empregam. Essas tecnologias de personalização são projetadas para selecionar apenas o conteúdo mais envolvente e relevante para cada usuário individual. Mas, ao fazê-lo, pode acabar reforçando os vieses cognitivos e sociais dos usuários, tornando-os ainda mais vulneráveis à manipulação.

Por exemplo, os detalhes ferramentas de publicidade incorporadas em muitas plataformas de mídia social deixe que os ativistas da desinformação explorem viés de confirmação by alfaiataria de mensagens para pessoas que já estão inclinadas a acreditar nelas.

Além disso, se um usuário clicar frequentemente nos links do Facebook de uma fonte de notícias específica, o Facebook tendem a mostrar essa pessoa mais do conteúdo desse site. Este assim chamadobolha de filtroO efeito pode isolar as pessoas de diversas perspectivas, fortalecendo o viés de confirmação.

Nossa própria pesquisa mostra que as plataformas de mídia social expõem os usuários a um conjunto de fontes menos diversificado do que os sites de mídia não social, como a Wikipédia. Porque isso é no nível de uma plataforma inteira, não de um único usuário, nós chamamos isso de viés de homogeneidade.

Outro ingrediente importante das mídias sociais é a informação que está tendendo na plataforma, de acordo com o que está recebendo mais cliques. Nós chamamos isso viés de popularidade, porque descobrimos que um algoritmo projetado para promover conteúdo popular pode afetar negativamente a qualidade geral das informações na plataforma. Isso também alimenta o viés cognitivo existente, reforçando o que parece ser popular, independentemente de sua qualidade.

Todos esses vieses algorítmicos podem ser manipulados por bots sociais, programas de computador que interagem com humanos através de contas de mídia social. A maioria dos bots sociais, como o Twitter Big Bensão inofensivos. No entanto, alguns ocultam sua natureza real e são usados para intenções maliciosas, como impulsionando a desinformação ou falsamente criando a aparência de um movimento de base, também chamado de "astroturfing". Encontramos evidência deste tipo de manipulação no período que antecede a eleição da 2010 nos EUA.

Para estudar essas estratégias de manipulação, desenvolvemos uma ferramenta para detectar bots sociais chamados Botómetro. O Botometer usa o aprendizado de máquina para detectar contas de bots, inspecionando milhares de recursos diferentes das contas do Twitter, como os tempos de seus posts, com que frequência os tweets e as contas que seguem e os retweets. Não é perfeito, mas revelou que tantos quanto 15 por cento das contas do Twitter mostram sinais de serem bots.

Usando o Botometer em conjunto com o Hoaxy, analisamos o núcleo da rede de desinformação durante a campanha presidencial norte-americana do 2016. Encontramos muitos bots explorando os vieses cognitivos, de confirmação e de popularidade de suas vítimas e os vieses algorítmicos do Twitter.

Esses bots são capazes de construir bolhas de filtro em torno de usuários vulneráveis, alimentando falsas alegações e desinformações. Primeiro, eles podem atrair a atenção de usuários humanos que apóiam um determinado candidato, twittando as hashtags desse candidato ou mencionando e retweetando a pessoa. Em seguida, os bots podem ampliar as falsas alegações que contaminam os oponentes, retweetando artigos de fontes de baixa credibilidade que correspondem a determinadas palavras-chave. Essa atividade também faz com que o algoritmo destaque para outras histórias falsas de usuários que estão sendo amplamente compartilhadas.

Entendendo vulnerabilidades complexas

Mesmo que nossa pesquisa e outras, mostrem como indivíduos, instituições e até mesmo sociedades inteiras podem ser manipuladas nas mídias sociais, existem muitas questões esquerda para responder. É especialmente importante descobrir como esses diferentes vieses interagem entre si, criando potencialmente vulnerabilidades mais complexas.

Ferramentas como a nossa oferecem aos usuários da Internet mais informações sobre desinformação e, portanto, algum grau de proteção contra seus danos. As soluções serão provavelmente não será apenas tecnológico, embora provavelmente haja alguns aspectos técnicos para eles. Mas eles devem levar em conta os aspectos cognitivos e sociais do problema.

Sobre os Autores

Giovanni Luca Ciampaglia, pesquisador assistente do Instituto de Ciência de Rede da Universidade de Indiana, Universidade de Indiana e Filippo Menczer, professor de Ciência da Computação e Informática; Diretor do Centro de Redes Complexas e Pesquisa de Sistemas, Universidade de Indiana

Este artigo foi originalmente publicado em A Conversação. Leia o artigo original.

Livros relacionados

at

Obrigado pela visita InnerSelf.com, onde existem 20,000+ artigos que alteram vidas promovendo "Novas Atitudes e Novas Possibilidades". Todos os artigos são traduzidos para Mais de 30 idiomas. Subscrever à InnerSelf Magazine, publicada semanalmente, e ao Daily Inspiration de Marie T Russell. Revista Innerself é publicado desde 1985.

Obrigado pela visita InnerSelf.com, onde existem 20,000+ artigos que alteram vidas promovendo "Novas Atitudes e Novas Possibilidades". Todos os artigos são traduzidos para Mais de 30 idiomas. Subscrever à InnerSelf Magazine, publicada semanalmente, e ao Daily Inspiration de Marie T Russell. Revista Innerself é publicado desde 1985.